Kubernetes:从Cloud Provider到Cloud Controller Mananger全解析_uninitialized=true:noschedule-程序员宅基地

技术标签: 云原生 Cloud Controller Manager Cloud Provider Kubernetes

一、背景

1.1 基于Kubernetes的容器云

容器云最主要的功能帮助用户把应用以容器的形式在集群中跑起来。目前很多的容器云平台通过Docker及Kubernetes等技术提供应用运行平台,从而实现运维自动化、快速部署应用、弹性伸缩和动态调整应用环境资源,提高研发运营效率。

1.2 Cloud Provider与云厂商

为了更好的让Kubernetes在公有云平台上运行,提供容器云服务,云厂商需要实现自己的Cloud Provider,即实现cloudprovider.Interface(https://github.com/kubernetes/kubernetes/blob/master/pkg/cloudprovider/cloud.go)。

它是Kubernetes中开放给云厂商的通用接口,便于Kubernetes自动管理和利用云服务商提供的资源,这些资源包括虚拟机资源、负载均衡服务、弹性公网IP、存储服务等。

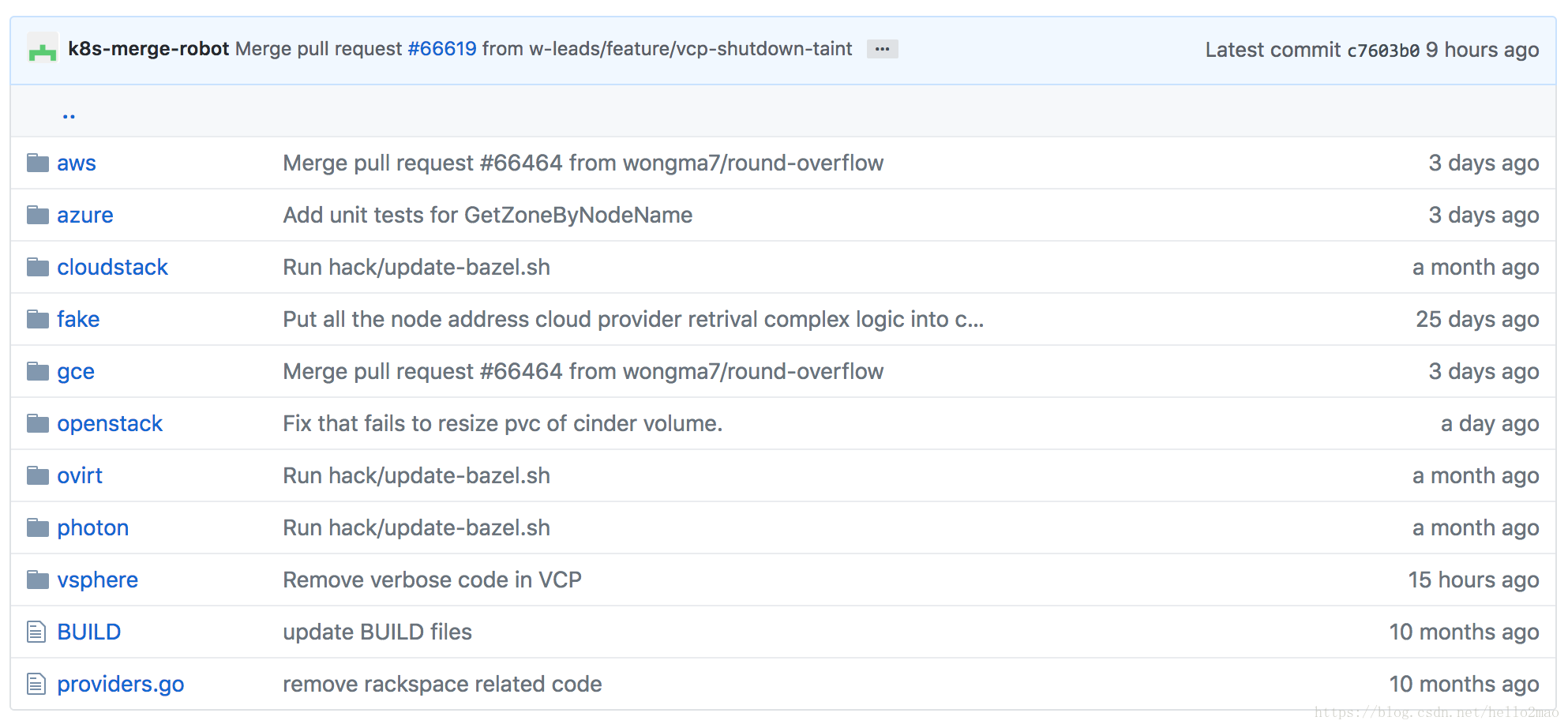

如下图所示,Kubernetes核心库内置了很多主流云厂商的实现,包括aws、gce、azure:

1.3 Cloud Provider的重构之路

但是,问题随之而来。

随着Kubernetes成为在私有云、公有云和混合云环境中大规模部署容器化应用的事实标准,越来越多的云厂商加入了进来,Cloud Provider的实现也越来越多,作为在Kubernetes核心库中的代码,这必将影响其快速的更新和迭代。

所以产生了把Cloud Provider移出Kubernetes核心库并进行重构的提案(Refactor Cloud Provider out of Kubernetes Core)。

在k8s v1.6,引入了Cloud Controller Manager(CCM),目的就是最终替代Cloud Provider。截止到最新的k8s v1.11,还是处于beta阶段。

二、Cloud Provider解析

2.1 Cloud Provider的作用

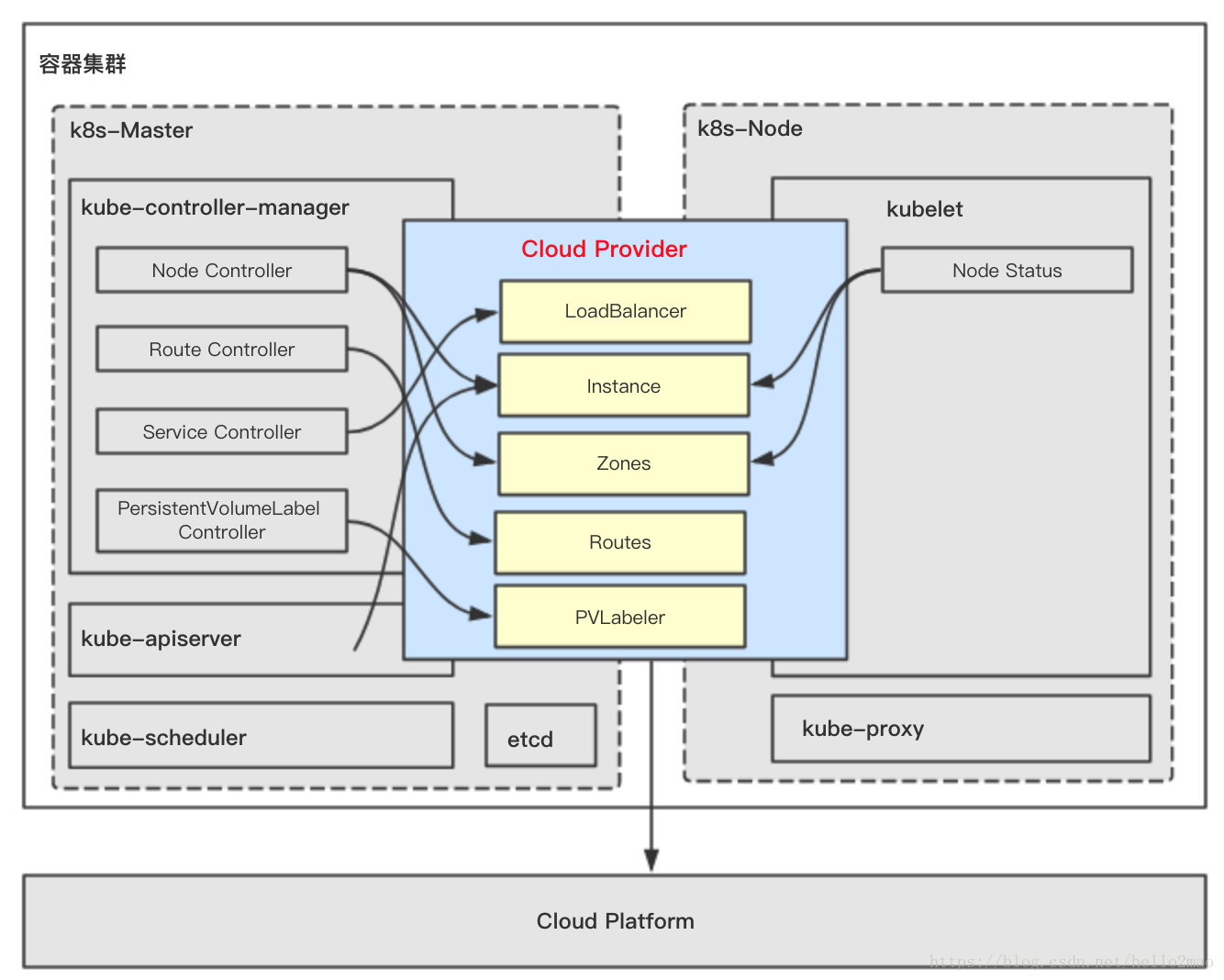

在k8s中有三个组件对Cloud Provider有依赖,分别是:

- kube-controller-manager

- kubelet

- kube-apiserver

这三个组件对Cloud Provider的依赖部分会最终编译进相应的二进制中,进一步的依赖关系如下图所示:

2.1.1 kube-controller-manager依赖Cloud Provider相关部分

kube-controller-manager对Cloud Provider的依赖分布在四个controller中。

2.1.1.1 Node Controller

Node Controller使用Cloud Provider来检查node是否已经在云上被删除了,如果Cloud Provider返回有node被删除了,那么Node Controller立马就会把此node从k8s中删除。

2.1.1.2 Route Controller

用来配置node的路由。

对于Kubernetes的容器网络,基本的原则是:每个pod都拥有一个独立的IP地址(IP per Pod),而且假定所有的pod都在一个可以直接连通的、扁平的网络空间中。而在云上,node的基础设施是由云厂商提供的,所以Route Controller需要调用Cloud Provider来配置云上node的底层路由从而实现Kubernetes的容器网络。

2.1.1.3 Service Controller

Service Controller维护了当前可用node的列表,同时负责创建、删除、更新类型是LoadBalancer的Service,从而使用云厂商额外提供的负载均衡服务、弹性公网IP等服务。

2.1.1.4 PersistentVolumeLabel Controller

PersistentVolumeLabel Controller使用Cloud Provider来创建、删除、挂载、卸载node上的卷,因为卷也是云厂商额外提供的云存储服务。

2.1.2 kubelet依赖Cloud Provider相关部分

kubelet中的Node Status使用Cloud Provider来获得node的信息。包括:

- nodename:运行kubelet的节点名字

- InstanceID, ProviderID, ExternalID, Zone Info:初始化kubelet的时候需要

- 周期性的同步node的IP

2.1.3 kube-apiserver依赖Cloud Provider相关部分

kube-apiserver使用Cloud Provider来给所有node派发SSH Keys。

2.2 Cloud Provider的设计

云厂商在实现自己的Cloud Provider时只需要实现cloudprovider.Interface即可,如下:

type Interface interface {

// 初始化一个k8s client,用于和kube-apiserver通讯

Initialize(clientBuilder controller.ControllerClientBuilder)

// 与负载均衡相关的接口

LoadBalancer() (LoadBalancer, bool)

// 与节点信息相关的接口

Instances() (Instances, bool)

// 与节点可用区相关的接口

Zones() (Zones, bool)

// 与集群相关的接口

Clusters() (Clusters, bool)

// 与路由相关的接口

Routes() (Routes, bool)

// cloud provider ID.

ProviderName() string

// ClusterID

HasClusterID() bool

}重点讲下两个比较重要的接口LoadBalancer()与Routes()。

2.2.1 LoadBalancer()的接口设计

LoadBalancer()接口用来为kube-controller-manager的Service Controller服务,接口说明如下:

type LoadBalancer interface {

// 根据clusterName和service返回是否存LoadBalancer,若存在则返回此LoadBalancer的状态信息,状态信息里包含此LoadBalancer的对外IP和一个可选的HostName

GetLoadBalancer(ctx context.Context, clusterName string, service *v1.Service) (status *v1.LoadBalancerStatus, exists bool, err error)

// 更新或者创建一个LoadBalancer,在用户创建一个type是LoadBalancer的Service时触发。

EnsureLoadBalancer(ctx context.Context, clusterName string, service *v1.Service, nodes []*v1.Node) (*v1.LoadBalancerStatus, error)

// 更新一个LoadBalancer,在Service信息发生改变或者集群信息发生改变时,例如集群新加入一个节点,那么需要更新下LoadBalancer,目的是为LoadBalancer更新下后端需要监听的新节点。

UpdateLoadBalancer(ctx context.Context, clusterName string, service *v1.Service, nodes []*v1.Node) error

// 删除一个LoadBalancer

EnsureLoadBalancerDeleted(ctx context.Context, clusterName string, service *v1.Service) error

}2.2.2 Routes()的接口设计

Routes()接口用来为kube-controller-manager的Route Controller服务,接口说明如下:

type Routes interface {

// 列举集群的路由规则

ListRoutes(ctx context.Context, clusterName string) ([]*Route, error)

// 为当前集群新建路由规则

CreateRoute(ctx context.Context, clusterName string, nameHint string, route *Route) error

// 删除路由规则

DeleteRoute(ctx context.Context, clusterName string, route *Route) error

}三、从Cloud Provider到Cloud Controller Manager

从k8s v1.6开始,k8s的编译产物中多了一个二进制:cloud-controller manager,它就是用来替代Cloud Provider的。

因为原先的Cloud Provider与mater中的组件kube-controller-manager、kube-apiserver以及node中的组件kubelet耦合很紧密,所以这三个组件也需要相应的进行重构。

3.1 kube-controller-manager的重构策略

kube-controller-manager中有四个controller与Cloud Provider相关,相应的重构策略如下:

- Route Controller

- 移入CCM,并在相应的controller loop中运行。

- Service Controller

- 移入CCM,并在相应的controller loop中运行。

- PersistentVolumeLabel Controller

- 移入CCM,并在相应的controller loop中运行。

- Node Controller

- 在CCM中增加新controller:Cloud Node Controller。

- Cloud Node Controller除了实现原来Node Controller的功能外,增加新功能:

- CIDR的管理

- 监控节点的状态

- 节点Pod的驱逐策略

3.2 kube-apiserver的重构策略

对于kube-apiserver使用Cloud Provider的两个功能:

- 分发SSH Keys

- 移入CCM

- 对于PV的Admission Controller

- 在kubelet中实现

3.3 kubelet的重构策略

kubelet需要增加一个新功能:在CCM还未初始化kubelet所在节点时,需标记此节点类似“NotReady”的状态,防止scheduler调度pod到此节点时产生一系列错误。此功能通过给节点加上如下Taints并在CCM初始化后删去此Taints实现:

node.cloudprovider.kubernetes.io/uninitialized=true:NoSchedule四、Cloud Controller Manager解析

4.1 Cloud Controller Manager架构

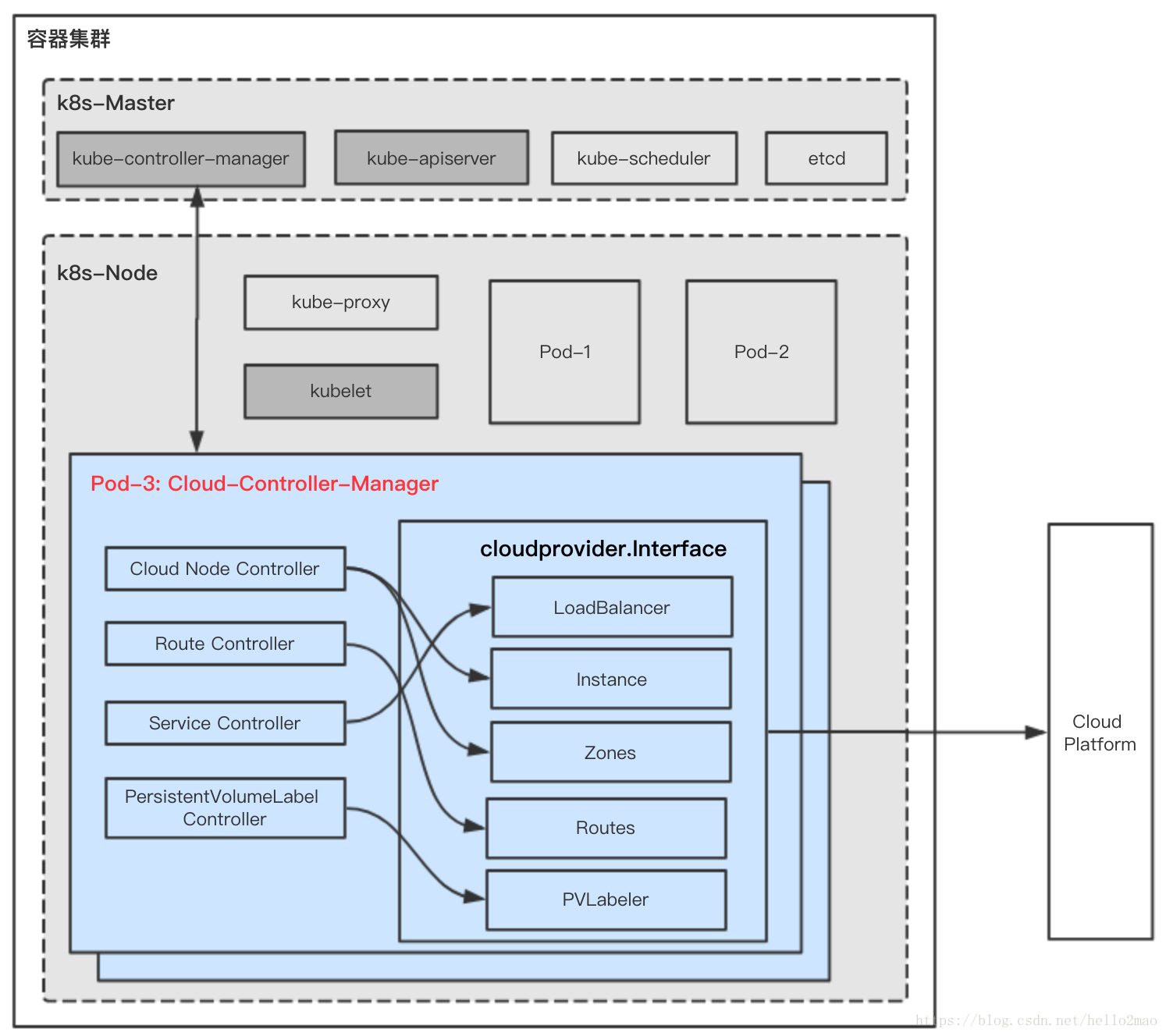

按照第三节所述进行重构后,新的模块Cloud Controller Manager将作为一个新的组件直接部署在集群内,如下图所示:

CCM组件内各小模块的功能与原先Cloud Provider的差不多,见第二节对Cloud Provider的解析。

对于云厂商来说,需要:

(1)实现cloudprovider.Interface接口的功能,这部分在Cloud Provider中已经都实现,直接迁移就行。

(2)实现自己的Cloud Controller Manager,并在部署k8s时,把CCM按要求部署在集群内,部署时的注意事项及部署参考实践见第五节。

4.2 Cloud Controller Manager实现举例

实现自己的CCM也比较简单,举例如下:

package main

import (

...

"k8s.io/kubernetes/cmd/cloud-controller-manager/app"

"k8s.io/kubernetes/cmd/cloud-controller-manager/app/options"

// (1)初始化原来Cloud Provider的相关逻辑,读取cloud配置、初始化云厂商的Clod SDK。

_ "k8s.io/cloud-provider-baiducloud/pkg/cloud-provider"

)

func main() {

goflag.CommandLine.Parse([]string{})

// (2) 初始化一个默认的CCM配置

s, _ := options.NewCloudControllerManagerOptions()

if err != nil {

glog.Fatalf("unable to initialize command options: %v", err)

}

// (3) CCM启动命令

cmd := &cobra.Command{

Use: "cloud-controller-manager",

Long: `The Cloud controller manager is a daemon that embeds the cloud specific control loops shipped with Kubernetes.`,

Run: func(cmd *cobra.Command, args []string) {

c, err := s.Config()

if err != nil {

fmt.Fprintf(os.Stderr, "%v\n", err)

os.Exit(1)

}

// (4) Run里会运行相关controller loops:CloudNode Controller、PersistentVolumeLabel Controller、Service Controller、Route Controller

if err := app.Run(c.Complete()); err != nil {

fmt.Fprintf(os.Stderr, "%v\n", err)

os.Exit(1)

}

},

}

s.AddFlags(cmd.Flags())

pflag.CommandLine.SetNormalizeFunc(flag.WordSepNormalizeFunc)

pflag.CommandLine.AddGoFlagSet(goflag.CommandLine)

logs.InitLogs()

defer logs.FlushLogs()

if err := c.Execute(); err != nil {

fmt.Fprintf(os.Stderr, "%v\n", err)

os.Exit(1)

}

}五、部署使用Cloud Controller Manager实践

5.1 总体要求

- 云厂商提供给CCM的API需要有认证鉴权机制,防止恶意行为。

- 因为CCM运行在集群内,所以需要RBAC规则去跟kube-apiserver通讯

- CCM为了高可用,可开启选主功能

5.2 k8s相关组件的启动配置变化

将Cloud Provider改为CCM后,相关组件启动的配置需要修改。

5.2.1 kube-controller-manager启动配置变化

不指定cloud-provider。

5.2.2 kube-apiserver启动配置变化

(1)不指定cloud-provider

(2)admission-control中删去PersistentVolumeLabel,因为CCM将接手PersistentVolumeLabel

(3)admission-control中增加Initializers

(4)runtime-config中增加admissionregistration.k8s.io/v1alpha1

5.2.3 kubelet启动配置变化

指定cloud-provider=external,告诉kubelet,在它开始调度工作前,需要被CCM初始化。(node会被打上 Taints:node.cloudprovider.kubernetes.io/uninitialized=true:NoSchedule)

5.3 启动CCM举例

5.3.1 启用initializers并添加InitializerConifguration

CCM为了给PV打标签需要:

(1)启用initializers(https://kubernetes.io/docs/reference/access-authn-authz/extensible-admission-controllers/#enable-initializers-alpha-feature)

(2)添加InitializerConifguration:persistent-volume-label-initializer-config.yaml如下:

admin/cloud/pvl-initializer-config.yaml

kind: InitializerConfiguration

apiVersion: admissionregistration.k8s.io/v1alpha1

metadata:

name: pvlabel.kubernetes.io

initializers:

- name: pvlabel.kubernetes.io

rules:

- apiGroups:

- ""

apiVersions:

- "*"

resources:

- persistentvolumes5.3.2 创建CCM的RBAC

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: system:cloud-controller-manager

labels:

kubernetes.io/cluster-service: "true"

rules:

- apiGroups:

- ""

resources:

- nodes

verbs:

- '*'

- apiGroups:

- ""

resources:

- nodes/status

verbs:

- patch

- apiGroups:

- ""

resources:

- services

verbs:

- list

- watch

- patch

- apiGroups:

- ""

resources:

- services/status

verbs:

- update

- apiGroups:

- ""

resources:

- events

verbs:

- create

- patch

- update

# For leader election

- apiGroups:

- ""

resources:

- endpoints

verbs:

- create

- apiGroups:

- ""

resources:

- endpoints

resourceNames:

- "cloud-controller-manager"

verbs:

- get

- list

- watch

- update

- apiGroups:

- ""

resources:

- configmaps

verbs:

- create

- apiGroups:

- ""

resources:

- configmaps

resourceNames:

- "cloud-controller-manager"

verbs:

- get

- update

- apiGroups:

- ""

resources:

- serviceaccounts

verbs:

- create

- apiGroups:

- ""

resources:

- secrets

verbs:

- get

- list

# For the PVL

- apiGroups:

- ""

resources:

- persistentvolumes

verbs:

- list

- watch

- patch

---

kind: ClusterRoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: xxx-cloud-controller-manager

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: system:cloud-controller-manager

subjects:

- kind: ServiceAccount

name: cloud-controller-manager

namespace: kube-system5.3.3 启动CCM

可以通过DaemonSet或者Deployment的方式启动CCM:

---

apiVersion: v1

kind: ServiceAccount

metadata:

name: cloud-controller-manager

namespace: kube-system

---

apiVersion: extensions/v1beta1

kind: DaemonSet

metadata:

name: xxx-cloud-controller-manager

namespace: kube-system

labels:

k8s-app: xxx-cloud-controller-manager

spec:

selector:

matchLabels:

k8s-app: xxx-cloud-controller-manager

updateStrategy:

type: RollingUpdate

template:

metadata:

labels:

k8s-app: xxx-cloud-controller-manager

spec:

hostNetwork: true

nodeSelector:

node-role.kubernetes.io/master: ""

tolerations:

- key: node.cloudprovider.kubernetes.io/uninitialized

value: "true"

effect: NoSchedule

- key: node-role.kubernetes.io/master

operator: Exists

effect: NoSchedule

serviceAccountName: cloud-controller-manager

containers:

- name: cloud-controller-manager

image: xxx-cloud-controller-manager:v1.0.0

args:

- --cloud-config=/path/to/cloud-config.yaml

- --cloud-provider=xxx

- -v=4

volumeMounts:

- name: cfg

mountPath: /etc/xxx

readOnly: true

- name: kubernetes

mountPath: /etc/kubernetes

readOnly: true

volumes:

- name: cfg

secret:

secretName: xxx-cloud-controller-manager

- name: kubernetes

hostPath:

path: /etc/kubernetes六、参考

智能推荐

解决win10/win8/8.1 64位操作系统MT65xx preloader线刷驱动无法安装_mt65驱动-程序员宅基地

文章浏览阅读1.3w次。转载自 http://www.miui.com/thread-2003672-1-1.html 当手机在刷错包或者误修改删除系统文件后会出现无法开机或者是移动定制(联通合约机)版想刷标准版,这时就会用到线刷,首先就是安装线刷驱动。 在XP和win7上线刷是比较方便的,用那个驱动自动安装版,直接就可以安装好,完成线刷。不过现在也有好多机友换成了win8/8.1系统,再使用这个_mt65驱动

SonarQube简介及客户端集成_sonar的客户端区别-程序员宅基地

文章浏览阅读1k次。SonarQube是一个代码质量管理平台,可以扫描监测代码并给出质量评价及修改建议,通过插件机制支持25+中开发语言,可以很容易与gradle\maven\jenkins等工具进行集成,是非常流行的代码质量管控平台。通CheckStyle、findbugs等工具定位不同,SonarQube定位于平台,有完善的管理机制及强大的管理页面,并通过插件支持checkstyle及findbugs等既有的流..._sonar的客户端区别

元学习系列(六):神经图灵机详细分析_神经图灵机方法改进-程序员宅基地

文章浏览阅读3.4k次,点赞2次,收藏27次。神经图灵机是LSTM、GRU的改进版本,本质上依然包含一个外部记忆结构、可对记忆进行读写操作,主要针对读写操作进行了改进,或者说提出了一种新的读写操作思路。神经图灵机之所以叫这个名字是因为它通过深度学习模型模拟了图灵机,但是我觉得如果先去介绍图灵机的概念,就会搞得很混乱,所以这里主要从神经图灵机改进了LSTM的哪些方面入手进行讲解,同时,由于模型的结构比较复杂,为了让思路更清晰,这次也会分开几..._神经图灵机方法改进

【机器学习】机器学习模型迭代方法(Python)-程序员宅基地

文章浏览阅读2.8k次。一、模型迭代方法机器学习模型在实际应用的场景,通常要根据新增的数据下进行模型的迭代,常见的模型迭代方法有以下几种:1、全量数据重新训练一个模型,直接合并历史训练数据与新增的数据,模型直接离线学习全量数据,学习得到一个全新的模型。优缺点:这也是实际最为常见的模型迭代方式,通常模型效果也是最好的,但这样模型迭代比较耗时,资源耗费比较多,实时性较差,特别是在大数据场景更为困难;2、模型融合的方法,将旧模..._模型迭代

base64图片打成Zip包上传,以及服务端解压的简单实现_base64可以装换zip吗-程序员宅基地

文章浏览阅读2.3k次。1、前言上传图片一般采用异步上传的方式,但是异步上传带来不好的地方,就如果图片有改变或者删除,图片服务器端就会造成浪费。所以有时候就会和参数同步提交。笔者喜欢base64图片一起上传,但是图片过多时就会出现数据丢失等异常。因为tomcat的post请求默认是2M的长度限制。2、解决办法有两种:① 修改tomcat的servel.xml的配置文件,设置 maxPostSize=..._base64可以装换zip吗

Opencv自然场景文本识别系统(源码&教程)_opencv自然场景实时识别文字-程序员宅基地

文章浏览阅读1k次,点赞17次,收藏22次。Opencv自然场景文本识别系统(源码&教程)_opencv自然场景实时识别文字

随便推点

ESXi 快速复制虚拟机脚本_exsi6.7快速克隆centos-程序员宅基地

文章浏览阅读1.3k次。拷贝虚拟机文件时间比较长,因为虚拟机 flat 文件很大,所以要等。脚本完成后,以复制虚拟机文件夹。将以下脚本内容写入文件。_exsi6.7快速克隆centos

好友推荐—基于关系的java和spark代码实现_本关任务:使用 spark core 知识完成 " 好友推荐 " 的程序。-程序员宅基地

文章浏览阅读2k次。本文主要实现基于二度好友的推荐。数学公式参考于:http://blog.csdn.net/qq_14950717/article/details/52197565测试数据为自己随手画的关系图把图片整理成文本信息如下:a b c d e f yb c a f gc a b dd c a e h q re f h d af e a b gg h f bh e g i di j m n ..._本关任务:使用 spark core 知识完成 " 好友推荐 " 的程序。

南京大学-高级程序设计复习总结_南京大学高级程序设计-程序员宅基地

文章浏览阅读367次。南京大学高级程序设计期末复习总结,c++面向对象编程_南京大学高级程序设计

4.朴素贝叶斯分类器实现-matlab_朴素贝叶斯 matlab训练和测试输出-程序员宅基地

文章浏览阅读3.1k次,点赞2次,收藏12次。实现朴素贝叶斯分类器,并且根据李航《统计机器学习》第四章提供的数据训练与测试,结果与书中一致分别实现了朴素贝叶斯以及带有laplace平滑的朴素贝叶斯%书中例题实现朴素贝叶斯%特征1的取值集合A1=[1;2;3];%特征2的取值集合A2=[4;5;6];%S M LAValues={A1;A2};%Y的取值集合YValue=[-1;1];%数据集和T=[ 1,4,-1;..._朴素贝叶斯 matlab训练和测试输出

Markdown 文本换行_markdowntext 换行-程序员宅基地

文章浏览阅读1.6k次。Markdown 文本换行_markdowntext 换行

错误:0xC0000022 在运行 Microsoft Windows 非核心版本的计算机上,运行”slui.exe 0x2a 0xC0000022″以显示错误文本_错误: 0xc0000022 在运行 microsoft windows 非核心版本的计算机上,运行-程序员宅基地

文章浏览阅读6.7w次,点赞2次,收藏37次。win10 2016长期服务版激活错误解决方法:打开“注册表编辑器”;(Windows + R然后输入Regedit)修改SkipRearm的值为1:(在HKEY_LOCAL_MACHINE–》SOFTWARE–》Microsoft–》Windows NT–》CurrentVersion–》SoftwareProtectionPlatform里面,将SkipRearm的值修改为1)重..._错误: 0xc0000022 在运行 microsoft windows 非核心版本的计算机上,运行“slui.ex